【Transformerの基礎】Multi-Head Attentionの仕組み скачать в хорошем качестве

Повторяем попытку...

Скачать видео с ютуб по ссылке или смотреть без блокировок на сайте: 【Transformerの基礎】Multi-Head Attentionの仕組み в качестве 4k

У нас вы можете посмотреть бесплатно 【Transformerの基礎】Multi-Head Attentionの仕組み или скачать в максимальном доступном качестве, видео которое было загружено на ютуб. Для загрузки выберите вариант из формы ниже:

-

Информация по загрузке:

Скачать mp3 с ютуба отдельным файлом. Бесплатный рингтон 【Transformerの基礎】Multi-Head Attentionの仕組み в формате MP3:

Если кнопки скачивания не

загрузились

НАЖМИТЕ ЗДЕСЬ или обновите страницу

Если возникают проблемы со скачиванием видео, пожалуйста напишите в поддержку по адресу внизу

страницы.

Спасибо за использование сервиса ClipSaver.ru

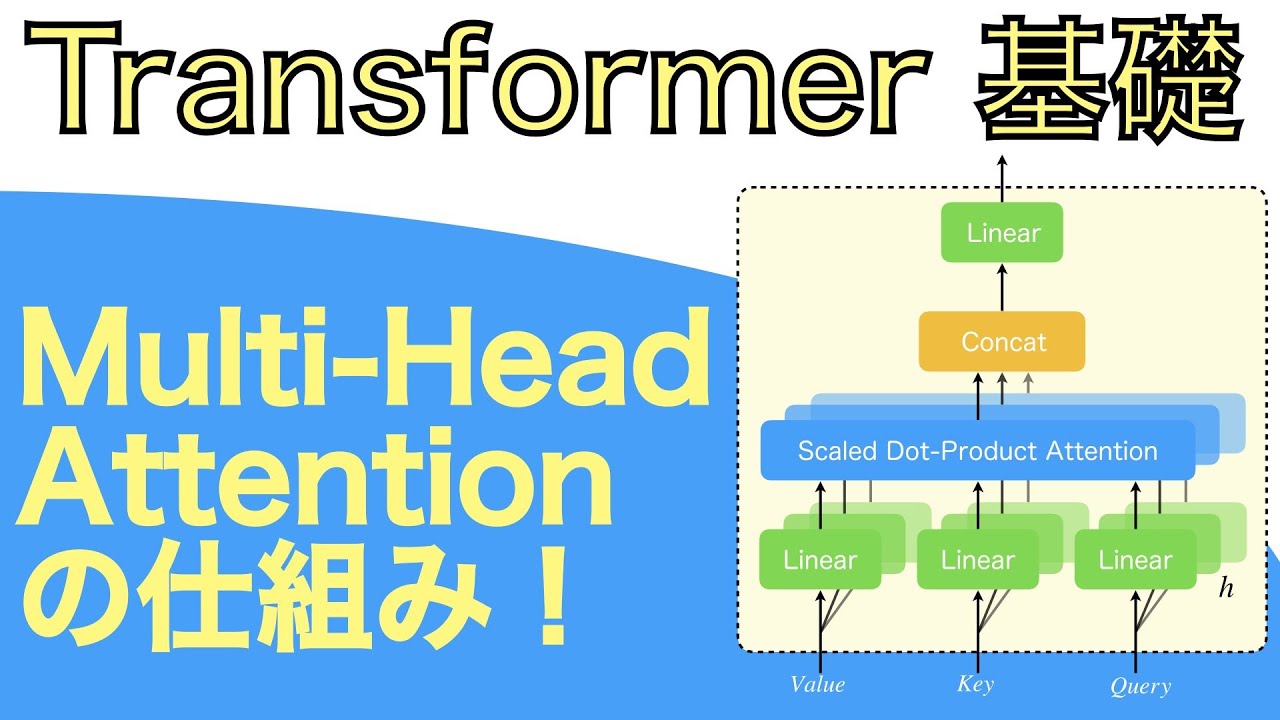

【Transformerの基礎】Multi-Head Attentionの仕組み

本動画では、Transformerの基礎として、Multi-Head Attentionの仕組みを分かりやすく解説しました。 以前に、「Transformerについて本質を分かりやすく解説」( • Transformerについて本質を分かりやすく解説! )とういう動画をアップしましたが、そこでは、Transformerの技術的な部分について詳しく説明していないため、本動画を追加で作成しました。この動画を見ればTransformerで使用されている、Multi-Head Attentionについて詳細を理解していただけるのではないかと思います。 Corrections: 15:10 d_kの説明が間違っておりました。d_kはトークン数ではなく、正しくはKeyを構成するベクトルの次元数です。申し訳ございません。 17:30 d_kの説明が間違っておりました。d_kはトークン数ではなく、正しくはKeyを構成するベクトルの次元数です。よって、図中の√5(5は具体例として示したI have a pen.のトークン数)は誤りであり、√d_kが図の表記として適切でした。該当記事の図は差し替えました。申し訳ございません。 ・解説に使用した記事 https://agirobots.com/multi-head-atte... ・Transformerに関する詳細な解説記事&動画 https://agirobots.com/attention-mecha... • 【速習!】Attentionから始めるTransformer超入門 ・RNNの解説記事&動画 https://agirobots.com/lstmgruentrance... • 直感で理解するLSTM・GRU入門 - 機械学習の基礎をマスターしよう! ブログ、Twitter、Instagramでも、情報を発信しています。 チャンネルの登録や、フォローお願いします! blog:https://agirobots.com/ twitter: / agirobots instagram: / agirobots