Young Researchers' Seminar: Herb Susmann and Juraj Bodík скачать в хорошем качестве

Повторяем попытку...

Скачать видео с ютуб по ссылке или смотреть без блокировок на сайте: Young Researchers' Seminar: Herb Susmann and Juraj Bodík в качестве 4k

У нас вы можете посмотреть бесплатно Young Researchers' Seminar: Herb Susmann and Juraj Bodík или скачать в максимальном доступном качестве, видео которое было загружено на ютуб. Для загрузки выберите вариант из формы ниже:

-

Информация по загрузке:

Скачать mp3 с ютуба отдельным файлом. Бесплатный рингтон Young Researchers' Seminar: Herb Susmann and Juraj Bodík в формате MP3:

Если кнопки скачивания не

загрузились

НАЖМИТЕ ЗДЕСЬ или обновите страницу

Если возникают проблемы со скачиванием видео, пожалуйста напишите в поддержку по адресу внизу

страницы.

Спасибо за использование сервиса ClipSaver.ru

Young Researchers' Seminar: Herb Susmann and Juraj Bodík

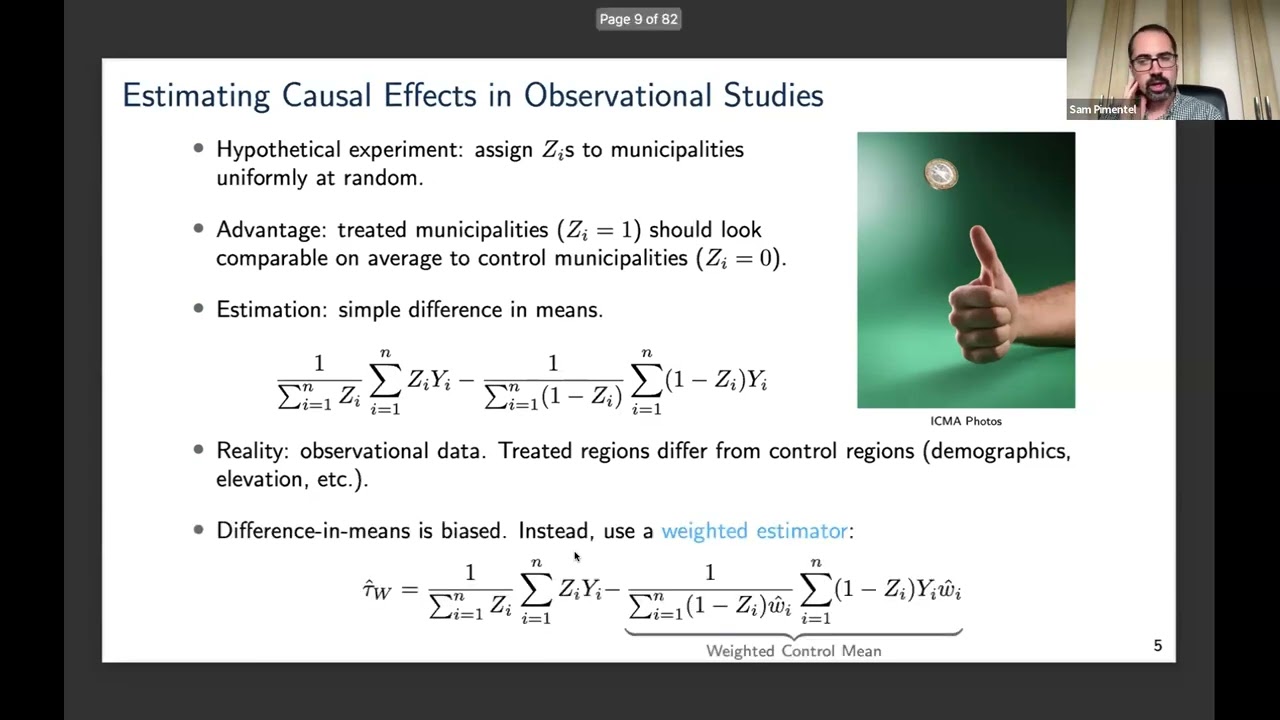

Subscribe to the channel to get notified when we release a new video. Like the video to tell YouTube that you want more content like this on your feed. See our website for future seminars: https://sites.google.com/view/ocis/home Tuesday, Feb 3rd, 2026: Young Researchers' Seminar Speaker 1: Herb Susmann (New York University) Title: Non-overlap Average Treatment Effect Bounds Abstract: The average treatment effect (ATE), the mean difference in potential outcomes under treatment and control, is a canonical causal effect. Overlap, which says that all subjects have non-zero probability of either treatment status, is necessary to identify and estimate the ATE. When overlap fails, the standard solution is to change the estimand, and target a trimmed effect in a subpopulation satisfying overlap; however, this no longer addresses the original goal of estimating the ATE. When the outcome is bounded, we demonstrate that this compromise is unnecessary. We derive non-overlap bounds: partial identification bounds on the ATE that do not require overlap. They are the sum of a trimmed effect within the overlap subpopulation and worst-case bounds on the ATE in the non-overlap subpopulation. Non-overlap bounds have width proportional to the size of the non-overlap subpopulation, making them informative when overlap violations are limited -- a common scenario in practice. Since the bounds are non-smooth functionals, we derive smooth approximations of them that contain the ATE but can be estimated using debiased estimators leveraging semiparametric efficiency theory. Specifically, we propose a Targeted Minimum Loss-Based estimator that is root-n consistent and asymptotically normal under nonparametric assumptions on the propensity score and outcome regression. We then show how to obtain a uniformly valid confidence set across all trimming and smoothing parameters with the multiplier bootstrap. This allows researchers to consider many parameters, choose the tightest confidence interval, and still attain valid coverage. We demonstrate via simulations that non-overlap bound estimators can detect non-zero ATEs with higher power than traditional doubly-robust point estimators. We illustrate our method by estimating the ATE of right heart catheterization on mortality. Speaker 2: Juraj Bodík (University of Lausanne, Switzerland) Title: Causality and Extreme Events: Why Additive Models Can Be Dangerous and What to Do Instead Abstract: Extreme events, outliers, and heavy-tailed behavior are the rule rather than the exception in many causal systems. Although additive-noise models of the form Y=f(X)+e massively dominate the literature, they can be a poor choice in such systems, when causal effects act primarily through the tail or the variance. This can potentially lead to seriously misleading conclusions. In this talk, I discuss two complementary approaches for causal reasoning in such regimes. For i.i.d. data, I introduce Conditionally Parametric Causal Models (CPCM), which move beyond mean-oriented additive formulations to accommodate heteroscedasticity and heavy tails. For time series, where temporal structure can be an ally rather than a nuisance, I present a framework for Granger-type causality in extremes, designed to detect and characterize causal links solely from extreme events.